- 2021年11月 9日

- [国際事務局発表ニュース]

- 国・地域:

- トピック:

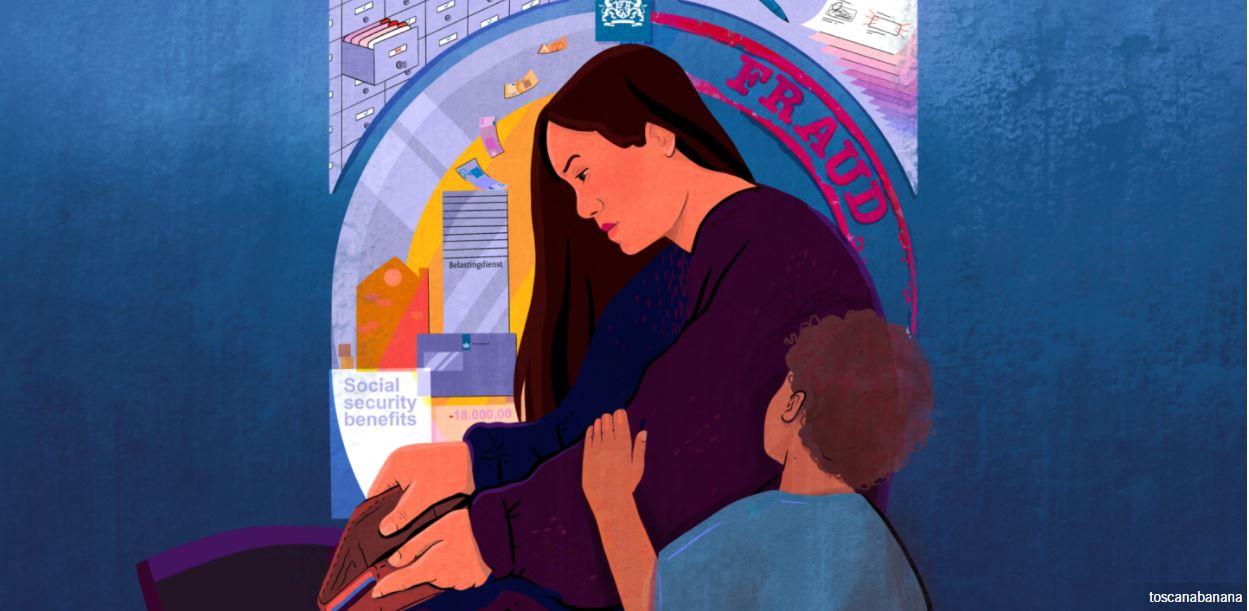

オランダ政府が、児童手当の申請手続きの中で人種差別を助長するおそれがある不適切なアルゴリズムの使用を続けてきたことが、アムネスティの調べでわかった。

同国の児童手当の電子申請システムでは、不正な申請や詐取を通知するアルゴリズム(特定の解を導き出すためのコンピュータ上の処理方法)の設計に人種差別的プロファイリング(統計的なデータなどから犯人像を推察する犯罪捜査の分析技法)機能が埋め込まれた。その結果、税務当局は、多くは低所得世帯出身の何万という親や保護者を、根拠ない詐取容疑で告発しており、少数民族の人びとなどに対し生活が立ちいかなくなるなど甚大な影響を与えてきた。この不祥事は1月にオランダ政府に伝えられたが、度々の調査にもかかわらず十分な処置がとられたとは言えない。

人種プロファイリングに基づく差別的アルゴリズムで、正当な申請を詐取とみなされた数千人は、受けられるはずの手当を受給できず、その生活は崩壊した。システム設計に人権保護の視点を欠く限り、オランダ政府は、市民を窮地に陥れる重大な誤りを繰り返すおそれがある。

またこれは、オランダだけの問題ではない。世界各国の政府が公的サービスの申請処理の自動化を急いでいるが、その代償を払っているのは、社会から最も置き去りにされている人びとだ。

アムネスティは、犯罪や詐欺が疑われる場合にリスク評価をする上で、捜査や調査で国籍や人種に関わる情報の使用を禁止する措置を直ちに取るよう世界各国に呼びかけている。

差別の連鎖

オランダの税務当局は2013年、児童手当の不正請求や詐取の検知にアルゴリズムを導入した。その当初から人種や民族に基づく差別が、アルゴリズムを設計する上で重視された。税務当局は、申請者がオランダ国籍か否かをリスク因子とし、オランダ国籍でない申請者には、高いリスク点数を与えた。

このシステムで選択された親や保護者は、手当の支給は見送られた上、厄介な審査を受けさせられ、厳しい規則、硬直した法解釈、支給再開を難しくする非情な政策などを適用された。そして、借金や失業、住宅からの強制退去に至るまで、深刻な問題に直面した。また人間関係の上で精神的不調やストレスを抱え、離婚や家庭崩壊に至った人もいる。

差別的アルゴリズムにより、人種や民族と犯罪を結びつける制度的偏見や、特定の人種や民族を社会に同化させる圧力が、強化されてきた。

こうした差別的な設計は、人の目が入らずにアルゴリズムが経験からの学習により自動で改良を重ねる自己学習メカニズムとなっているため、欠陥が再生されてしまう。その結果、オランダ国籍のない人びとは、オランダ国籍保有者に比べてより頻繁に不正を行う可能性があると指摘されてしまう、差別の連鎖が生まれる。

説明責任の不在

ある個人が不正リスクがあると注意喚起された場合、公務員はマニュアルに沿って不正リスクを確認する必要があるが、このシステムが何故高いリスク点数を出したかについては情報が与えられない。システムの入力と演算が目に見えないこうした不透明な「ブラックボックス」が、説明責任と監視の不在を作り出した。

オランダの税務当局が、このようなブラックボックスのシステムを使用し、適切な監視機構もなくアルゴリズムに意思決定を委ねたことで、説明責任にブラックホールができる結果となった。

アルゴリズムによる意思決定システムの効率の良さを示す必要があった税務当局には、不正の告発があった場合その真偽にかかわらず、できるだけ多くの税金を確保したいという倒錯した動機があった。

税務当局から児童手当の不正受給を指摘された人びとは、自分たちがどんな不正を働いたのか問い質したが、当局からの回答はなかった。

アムネスティが調査で得た知見は、10月26日に開かれた国連総会サイドイベントの一つのアルゴリズム差別のイベントで提起された。今年アムネスティは、公的部門で自動化された意志決定システムにおける人権上のリスクを調査し、キャンペーンを実施する学際チーム「アルゴリズム説明責任ラボ」を立ち上げる。

アムネスティは、各国政府に対し以下を求めている。

- アルゴリズムによる意思決定システムの利用に関連する人権侵害を防止する。具体的には、システム導入前に、法的拘束力ある人権への影響評価を実施するなど。

- 公共部門のアルゴリズムシステムの実効性ある監視とそのメカニズムを確立する。

- 人権侵害を行った責任者に説明を求め、権利が侵害された個人・グループにしっかりした救済策を提供する。

- 個人の権利に重大な影響を与えるおそれがある場合は、ブラックボックスシステムと自己学習アルゴリズムの使用を停止する。

アムネスティ国際ニュース

2021年10月25日